Comprenons-nous vraiment le comportement temporel des I/O dans les applications HPC — et pourquoi est-ce important ?

Retrouvez la version étendue de cet article « A Deep Look Into the Temporal I/O Behavior of HPC Applications » ici.

Exa-DoST est fier de partager sa dernière publication parue lors de la conférence IPDPS 2025 : Un regard approfondi sur le comportement temporel des E/S des applications HPC.

Dans le cadre d’une collaboration entre Inria (France), TU Darmstadt (Allemagne)et le LNCC (Brésil), Francieli Boito, Luan Teylo, Mihail Popov, Theo Jolivel, François Tessier, Jakob Luettgau, Julien Monniot, Ahmad Tarraf, André Carneiro et Carla Osthoff ont réalisé une étude à grande échelle sur le comportement temporel des entrées/sorties (I/O) en calcul haute performance (HPC), basée sur plus de 440 000 traces collectées sur 11 ans auprès de quatre grands systèmes HPC.

Comprendre le comportement temporel des I/O est essentiel pour améliorer les performances des applications HPC, en particulier alors que l’écart entre les vitesses de calcul et celles des I/O ne cesse de s’accentuer. De nombreuses techniques existantes — telles que l’allocation de buffers intermédiaires (burst buffers), la planification des I/O ou la coordination des tâches par lots — reposent sur des hypothèses concernant ce comportement. Ce travail examine des questions fondamentales liées à la temporalité, la périodicité et la concurrence des I/O dans des charges de travail réelles. En analysant les traces du point de vue à la fois du système et des applications, nous proposons une caractérisation détaillée des interactions entre les applications HPC et le sous-système I/O au fil du temps.

Principales contributions :

-

Une classification des motifs temporels récurrents dans des charges de travail variées.

-

Des observations sur la concurrence des I/O et l’utilisation partagée des ressources.

-

La mise à disposition publique des jeux de données utilisés afin de soutenir la recherche future.

Nos résultats constituent une base empirique solide pour le développement d’outils de monitoring adaptés au comportement des applications, de nouvelles stratégies de planification des I/O, et de modèles de performance plus précis.

Lisez la version complète sur HAL.

Crédit photo : Francieli Boito

2025 InPEx workshop

Retrouvez toute la présentation sur le site d'InPEx ici

Du 14 au 17 avril 2025, le réseau international d’experts InPEx (Europe, Japon, USA) se réunit à Kanagawa, au Japon, pour le workshop 2025, dédié aux défis de l’ère post-Exascale. Un événement accueilli par RIKEN-CSS et des universités japonaises, avec le soutien du programme de recherche NumPEx

Retrouvez toutes les contributions de NumPEx ci-dessous :

- Introduction, avec Jean-Yves Berthou, directeur Inria du NumPEx et représentant pour l’Europe

-

IA et HPC : partage de benchmarks centrés sur l’IA pour les flux de travail hybrides

Co-présidé par Jean-Pierre Vilotte (CNRS) -

Production et gestion de logiciels

Co-présidé par Julien Bigot (CEA) -

IA et HPC : IA générative pour la science

Co-présidé par Alfredo Buttari (IRIT) et Thomas Moreau (Inria) -

Continuum numérique et gestion des données

Co-présidé par Gabriel Antoniu (Inria)

Si vous souhaitez en savoir plus, toutes les présentations sont disponibles sur le site web d’InPEx.

Crédit photo : Corentin Lefevre/Neovia Innovation/Inria

Première assemblée générale de NumPEx

Réunissant 130 chercheurs, ingénieurs et partenaires à Inria Saclay, l’assemblée générale 2025 de NumPEx a constitué une étape importante pour le futur de notre programme de recherche.

Pendant deux jours, les participantes et participants ont pris part à des discussions, ateliers et conférences exposant un panorama des défis liés à une informatique Exascale à grande échelle. La première journée a notamment été marquée par l’annonce en direct que la France avait été sélectionnée pour accueillir l’une des IA Factories.

Cette assemblée générale a également été l’occasion d’introduire YoungPEx à l’ensemble de la communauté du programme à travers une présentation et un de ses premiers ateliers. YoungPEx est une nouvelle initiative visant à favoriser la collaboration entre les jeunes chercheurs et chercheuses, doctorantes et doctorants, post-doctorantes et post-doctorants, ingénieures et ingénieurs et personnels permanents bénévoles. Elle servira à former un réseau dynamique pour l’échange de connaissances et la collaboration interdisciplinaire au sein des communautés HPC et IA.

Nous avons également eu le plaisir d’accueillir les programmes de recherche TRACCS et Cloud, qui ont présenté des collaborations en cours et potentielles avec NumPEx.

Avec cette première assemblée générale, NumPEx renforce sa communauté et poursuit sa route vers l’Exascale et bien au-delà.

© PEPR NumPEx

La réunion annuelle 2025 d'Exa-MA

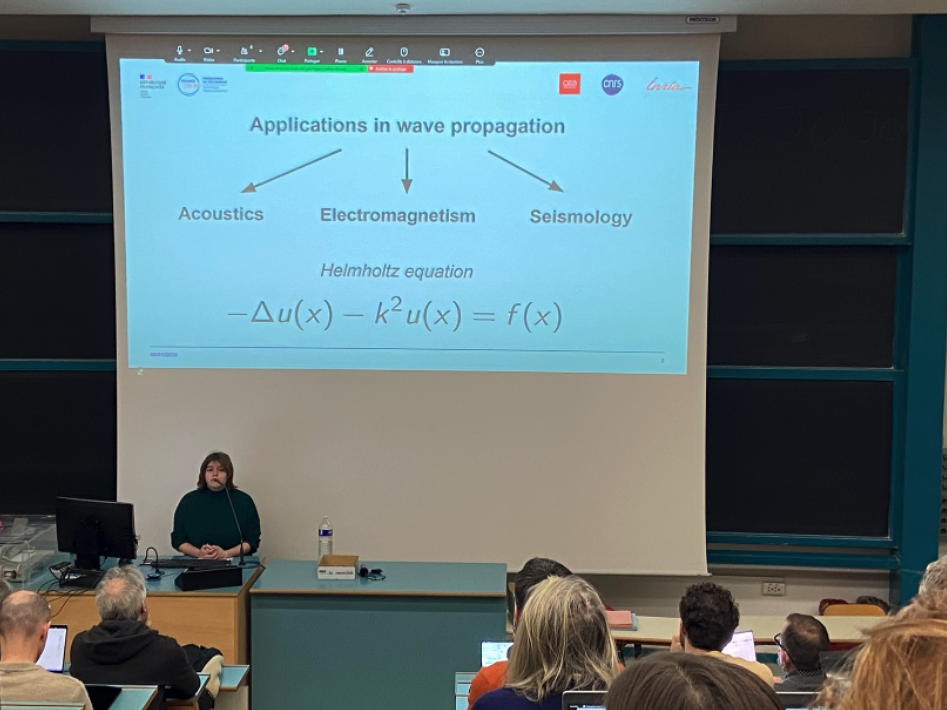

L’Assemblée générale du projet Exa-MA s’est tenue à l’Université de Strasbourg les 14 et 15 janvier 2025. Cet événement de deux jours a été l’occasion de partager les dernières avancées du projet, de renforcer les collaborations entre les Work Packages (WPs) et de discuter des prochaines étapes.

Exa-MA vise à révolutionner les méthodes et algorithmes pour l’échelle exascale : discrétisation, résolution, apprentissage et réduction d’ordre, problème inverse, optimisation et incertitudes. Nous contribuons à la pile logicielle des futurs ordinateurs européens.

L’assemblée générale a réuni 83 participants, dont des membres du conseil scientifique, des partenaires externes et de jeunes recrues, 15 d’entre eux s’étant inscrits en ligne. L’événement comprenait des sessions plénières, des ateliers thématiques et des discussions stratégiques axées sur les synergies intra- et inter-projets, en particulier avec Exa-Soft et Exa-DI. Les principaux sujets abordés ont été l’IA, les accélérateurs, la durabilité des logiciels et les collaborations externes. Le renforcement des liens avec les partenaires universitaires et industriels a également constitué un axe majeur, renforçant le rôle d’Exa-MA dans l’écosystème plus large du calcul exascale.

Mardi 14 janvier 2025

- Accueil et présentations générales

par Hélène Barucq, chercheur Inria

et Christophe Prud’homme, professeur à l’Université de Strasbourg - Les nouvelles recrues à l’honneur

- Hung Truong, chercheur postdoctoral à l’Inria

- Céline Van Landeghem, doctorante à l’Université de Strasbourg

- Thomas Saigre, chercheur à l’Université de Strasbourg

- Christos Giorgadis, chercheur postdoctoral à l’Inria

- Daria Hrebenshchykova, doctorante à l’Université Côte d’Azur

- Mahamat Nassouradine, doctorant au CEA

- Groupe de travail transversal sur l’IA

par Emmanuel Franck, chercheur à l’Inria - Les nouvelles recrues à l’honneur

- Antoine Simon, ingénieur de recherche au CEA

- Sébastien Dubois, ingénieur de recherche au CEA

- Alexandre Hoffmann, doctorant Inria

- Atelier général sur les interactions au sein du projet

par Mark Asch, professeur à l’Université de Picardie

Luc Giraud, chercheur à l’Inria

Jean-Pierre Vilotte, chercheur au CNRS - Les nouvelles recrues à l’honneur

- Alexandre Pugin, doctorant Inria

- Hélène Hénon, doctorante à l’Université Grenoble Alpes

- Hassan Ballout, doctorant à l’Université de Strasbourg

- Présentation du groupe de travail transversal NumPEx sur les accélérateurs (GPU)

par Philippe Helluy, professeur à l’Université de Strasbourg - Les nouvelles recrues à l’honneur

- Pierre Dubois, doctorant au CEA

- Amaury Bélières, étudiant en doctorat à l’Université de Strasbourg

- Réunion privée du conseil scientifique

Mercredi 15 janvier 2025

- Atelier général sur les interactions avec les partenaires extérieurs

par Hélène Barucq et Christophe Prud’homme - Atelier sur les WP1 et WP3 : discrétisation et solveurs

par Isabelle Ramière, chercheur au CEA

Pierre Alliez, chercheur à l’Inria,

Hélène Barucq et Vincent Faucher, chercheur au CEA - Atelier sur les WP2 et WP5 : optimisation et IA

par El Ghazali Talbi, professeur à l’Université de Lille

Stéphane Lanteri, chercheur Inria

et Emmanuel Franck - Atelier sur les WP4 et WP6 : quantification de l’incertitude + problèmes inverses & assimilation de données

Josselin Garnier, professeur à l’École polytechnique

Clément Gauchy, chargé de recherche au CEA

Arthur Vidard, chargé de recherche à l’Inria

Hélène Barucq et Florian Faucher, chargé de recherche à l’Inria - Retour sur l’atelier 1

par Isabelle Ramière, Vincent Faucher et Pierre Alliez - Retour d’expérience sur l’atelier 2

par El Ghazali Talbi - Retour sur l’atelier 3

par Josselin Garnier et Arthur Vidard - Conclusion

par Christophe Prud’homme - Échanges informels

Participantes et participants

- Pierre Alliez, Inria

- Ani Anciaux Sedrakian, IFPEN (en ligne)

- Mark Asch, Université de Picardie

- Hassan Ballout, Université de Strasbourg

- Hélène Barucq, Inria

- Amaury Bélières–Frendo, Université de Strasbourg

- Anne Benoit, ENS

- Jérôme Bobin, CEA

- Matthieu Boileau, Université de Strasbourg

- Jérôme Bonelle, EDF

- Jed Brown, Université du Colorado (en ligne)

- Ansar Calloo, CEA

- Vincent Chabannes, Université de Strasbourg

- Xinye Chen, Sorbonne Université (en ligne)

- Aurélien Citrain, Inria

- Javier Andrés Cladellas Herodier, Université de Strasbourg

- Susanne Claus, ONERA

- Raphaël Côte, Université de Strasbourg

- Clémentine Courtès, Université de Strasbourg

- Grégoire Danoy, Université de Luxembourg

- Etienne Decossin, EDF

- Romain Denefle, EDF

- Pierre Dubois, CEA

- Sébastien Dubois, École Polytechnique

- Talbi El-ghazali, Université de Lille

- Vincent Faucher, CEA

- Florian Faucher, Inria

- Emmanuel Franck, Inria

- Josselin Garnier, École Polytechnique

- Clément Gauchy, CEA

- Christos Georgiadis, Inria

- Christophe Geuzaine, Université de Liège (en ligne)

- Mathieu Goron, CEA (en ligne)

- Loic Gouarin, École Polytechnique

- Denis Gueyffier, ONERA (En ligne)

- Philippe Helluy, Université de Strasbourg

- Hélène Hénon, Inria

- Jan Hesthaven, Institut de technologie de Karlsruhe (en ligne)

- Alexandre Hoffmann, École Polytechnique

- Daria Hrebenshchykova, Inria

- Bertrand Iooss, EDF

- Fabienne Jézéquel, Université Paris-Panthéon-Assas (en ligne)

- Pierre Jolivet, CNRS (En ligne)

- Baptiste Kerleguer, CEA

- Mickael Krajecki, Université de Reims

- Catherine Lambert, CERFACS

- Pierre Ledac, CEA

- Patrick Lemoine, Université de Strasbourg

- Sébastien Loriot, Geometry Factory

- Giraud Luc, Inria

- Nassouradine Mahamat Hamdan, CEA

- Bahia Maoili, ANR (En ligne)

- Marc Massot, École Polytechnique

- Pierre Matalon, École Polytechnique

- Loïs McInnes, Laboratoire national d’Argonne (en ligne)

- Katherine Mer-Nkonga, CEA (en ligne)

- Victor Michel-Dansac, Inria

- Axel Modave, ENSTA (en ligne)

- Vincent Mouysset, ONERA

- Frédéric Nataf, Sorbonne Université

- Laurent Navoret, Université de Strasbourg

- Lars Nerger, Institut Alfred Wegener

- Augustin Parret-Fréaud, Safran

- Lucas Pernollet, CEA

- Raphaël Prat, CEA

- Clémentine Prieur, Université de Grenoble (en ligne)

- Christophe Prud’homme, Université de Strasbourg

- Alexandre Pugin, Inria

- Isabelle Ramiere, CEA

- Thomas Saigre, Université de Strasbourg

- Eric Savin, ONERA

- Antoine Simon, École Polytechnique

- Bruno Sudret, ETH Zürich

- Nicolas Tardieu, EDF

- Isabelle Terrasse, Airbus

- Sébastien Tordeux, Inria

- Pierre-Henri Tournier, Sorbonne Université

- Christophe Trophime, CNRS

- Hung Truong, Université de Strasbourg

- Céline Van Landeghem, Université de Strasbourg

- Arthur Vidard, Inria

- Jean-Pierre Vilotte, CNRS

- Raphael Zanella, Sorbonne Université (en ligne)

PEPR NumPEx

Lettre d'information NumPEx n°2 - 2025 avec NumPEx !

Redirection vers la newsletter... Si rien ne se passe, cliquez ici.

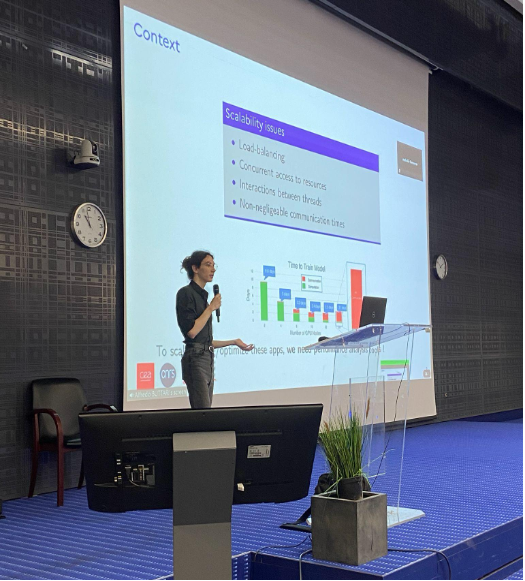

L'assemblée annuelle 2024 d'Exa-Soft

La deuxième assemblée annuelle d’Exa-SofT, qui s’est tenue les 7 et 8 novembre 2024 à l’ENSEEIHT à Toulouse, a rassemblé plus de 50 participants du monde académique et industriel pour partager les progrès des applications de calcul scientifique, renforcer les collaborations, et présenter les nouveaux membres d’Exa-SofT.

Jeudi, 07 novembre 2024

- Opening Talk

by Raymond Namyst, professor at University of Bordeaux

and Alfredo Buttari, CNRS research scientist - WP1 Scientific presentation – COMET: from dynamic data-parallel dataflows to task graphs

by Jerry Lacmou Zeutouo, associate professor at IUT Amiens

and Christian Perez, Inria research scientist - WP4 Scientific presentation – Tensor computations

Atte Torri, PhD student at Paris-Saclay University - General workshop – Exa-SofT software stack consolidation

animated by Abdou Guermouche, associate professor at University of Bordeaux

and Christian Perez - WP2 & WP1 Scientific presentation – Polyhedral model for Kokkos code optimization

by Ugo Battiston, Inria PhD student - WP3 Scientific presentation – Recursive tasks

by Thomas Morin, PhD student at University of Bordeaux - WP2 Scientific presentation – Automatic multi-versioning of computation kernels

by Raphaël Colin, Inria PhD student under the supervision of Philippe Clauss and Thierry Gautier - WP4 & WP6 Scientific presentation – Improving energy efficiency of HPC application

by Albert d’Aviau de Piolant, PhD student at University of Bordeaux

Vendredi 8 novembre 2024

- NumPEx Energy working group feedback

by Georges Da Costa, professor at University of Toulouse

and Amina Guermouche, associate professor at Bordeaux INP - General workshop – Exa-SofT developments integration in applications

by Marc Pérache, CEA research scientist

and François Trahay, professor at Telecom SudParis - WP5 Scientific presentation – PALLAS: a generic trace format for large HPC trace analysis

by Catherine Guelque, PhD student at Telecom ParisSud - WP5 & WP6 Scientific presentation – Fine-grain energy measurement

by Jules Risse, PhD student at Telecom ParisSud - NumPEx GPU working group feedback

Samuel Thibault, professor at University of Bordeaux

Participantes et participants

- Ugo Battinston, Inria

- Julien Bigot, CEA

- Alfredo Buttari, CNRS

- Philippe Clauss, Inria

- Henri Calandra, Total Energies

- Terry Cojean, Eviden

- Raphaël Colin, Inria

- Benoit Combemale, Inria

- Jean-Marie Couteyen, Airbus

- Albert d’Aviau de Piolant, Inria

- Georges Da Costa, Université de Toulouse

- Alexandre Denis, Inria

- Nicolas Ducarton, Inria

- Pierre Esterie, Inria

- Ewen Brune, Inria

- Mathieu Faverge, Inria

- Thierry Gautier, Inria

- David Goudin, Eviden

- Karmijn Hoogveld, Université de Toulouse

- Catherine Guelque, Telecom SudParis

- Amina Guermouche, Bordeaux INP

- Abdou Guermouche, Université de Bordeaux

- Julien Hermann, CNRS

- Jerry Lacmou Zeutouo, Université de Picardie

- Marc Pérache, CEA

- Raymond Namyst, Université de Bordeaux

- Nicolas Brieuc, Inria

- Alena Kopanicakova, Toulouse INP

- Christian Perez, Inria

- Luc Giraud, Inria

- Alejandro Estana, Université de Toulouse

- Lucas Pernollet, CEA

- Millian Poquet, Université de Toulouse

- Jules Risse, Telecom SudParis

- Julien Vanharen, Inria

- Alec Sadler, Inria

- Nicolas Renon, Université de Toulouse

- Philippe Swartvagher, Inria

- Samuel Thibault, Université de Bordeaux

- François Trahay, Telecom SudParis

- Pierre Matalon, École polytechnique

- Atte Torri, Université Paris-Saclay

- Bora Ucar, ENS

- Pierre-André Wacrenier, Université de Bordeaux

- Damien Gratadour, Université Paris Cité

- Petr Vacek, IFPEN

- Matthieu Robeyns, Université Paris-Saclay

- Nathalie Furmento, CNRS

© PEPR NumPEx

Le troisième atelier de co-conception et de co-développement d'Exa-DI sur "l'intelligence artificielle pour HPC@Exscale".

Le troisième atelier de co-conception/co-développement du projet Exa-DI (Développement et Intégration) du PEPR NumPEx était dédié à « l’Intelligence Artificielle pour HPC@Exscale » en ciblant les deux sujets « Image analysis @ exascale » et « Data analysis and robust inference @ exascale ». Il s’est déroulé les 2 et 3 octobre 2024 à l’Espace La Bruyère, Du Côté de la Trinité (DCT) à Paris.

This face-to-face workshop brought together, for two days, Exa-DI members, members of the other NumPEx projects (Exa-MA: Methods and Algorithms for Exascale, Exa-SofT: HPC Software and Tools, Exa-DoST: Data-oriented Software and Tools for the Exascale and Exa-AToW: Architectures and Tools for Large-Scale Workflows), Application demonstrators (ADs) from various research and industry sectors and Experts to discuss advancements and future directions for integration of Artificial Intelligence into HPC/HPDA workflows at exascale targeting the two topics, “Large image analysis” and “Data analysis and robust inference”.

This workshop is the third co-design/co-development workshops in the series whose main objective is to promote software stack co-development strategies to accelerate exascale development and performance portability of computational science and engineering applications. This workshop is a little different from the previous two in that it has a prospective character targeting the increasing importance of rapidly evolving AI-driven and AI-coupled HPC/HPDA workflows in “Large images analysis @ exascale” and “Data analysis (simulation, experiments, observation) & robust inference @ exascale”. Its main objectives are first to co-develop a shared understanding of the different modes of coupling AI into HPC/HPDA workflows, second to co-identify execution motifs most commonly found in scientific applications in order to drive the co-development of collaborative specific benchmarks or proxy apps allowing to evaluate/measure end-to-end performance of AI-coupled HPC/HPDA workflows and finally, to co-identify software components (libraries, frameworks, data communication, workflow tools, abstraction layers, programming and execution environments) to be co-developed and integrated to improve critical components and accelerate them.

Principales sessions

- Introduction and Context: Setting the stage for the workshop’s two main topics as well as presenting the GT IA, a transverse action in NumPEx.

- Attendees Self-Introduction: Allowing attendees to introduce themselves and their interests.

- Various Sessions: These sessions featured talks on the challenges to tackle and bottlenecks to overcome (execution speed, scalability, volume of data…), on the type, the format and the volume of data currently investigated, on the frameworks or programming languages currently used (e.g. python, pytorch, JAX, C++, etc..) and on the typical elementary operations performed on data.

- Discussions and Roundtables: These sessions provided opportunities for attendees to engage in discussions and share insights on the presented topics in order to determine a strategy to tackle the challenges in co-design and co-development process.

Conférencières et conférenciers invités

- Jean-Pierre Vilotte du CNRS, membre d’Exa-DI, qui a présenté le contexte introductif de l’atelier.

- Thomas Moreau de l’Inria, membre d’Exa-DoST, présentant la GT IA, une action transversale dans NumPEx.

- Tobias Liaudat du CEA, sur la quantification rapide et évolutive de l’incertitude pour l’imagerie scientifique.

- Damien Gradatour du CNRS, qui aborde la question de la construction de nouveaux cerveaux pour les télescopes astronomiques géants grâce aux réseaux neuronaux profonds (Deep Neural Networks).

- Antoine Petiteau du CEA, discutant de l’analyse des données pour l’observation de l’Univers avec les ondes gravitationnelles à basse fréquence.

- Kevin Sanchis de Safran AI, sur l’évaluation des méthodes d’apprentissage auto-supervisé dans le domaine de la télédétection.

- Hugo Frezat de l’Université Paris Cité, présentant des modèles d’apprentissage à l’échelle de la maille pour la convection turbulente en rotation.

- Benoit Semelin de la Sorbonne Université, discutant de l’inférence basée sur la simulation avec des simulations d’hydrodynamique radiative cosmologique pour le SKA.

- Bruno Raffin & Thomas Moreau de l’Inria, présentant l’analyse basée sur l’apprentissage automatique de grands résultats de simulation dans Exa-DoST.

- Julián Tachella du CNRS, présentant DeepInverse : une bibliothèque PyTorch pour résoudre des problèmes inverses avec l’apprentissage profond.

- Erwan Allys de l’ENS-PSL, explorant le modèle génératif et la séparation des composants dans un régime de données limitées avec la Transformée de diffusion.

- François Lanusse du CNRS, discutant du pré-entraînement multimodal pour les données scientifiques : Vers des modèles de grandes données pour l’astrophysique. > en ligne

- Christophe Kervazo de Telecom Paris, abordant les méthodes d’apprentissage profond interprétables et évolutives pour les problèmes inverses d’imagerie.

- Eric Anterrieu du CNRS, explorant l’approche basée sur l’apprentissage profond en radiométrie d’imagerie par synthèse d’ouverture et son implémentation.

- Philippe Ciuciu du CEA, sur l’IRM computationnelle à l’ère de l’apprentissage profond.

- Pascal Tremblin du CEA, caractérisant les modèles dans les simulations HPC à l’aide de la reconnaissance d’images et de la catégorisation pilotées par l’IA.

- Bruno Raffin de l’Inria, membre d’Exa-DI, présentant le Software Packaging dans Exa-DI

Conclusion et impacts

Many interesting and fruitful discussions took place during this prospective workshop. These discussions allowed us first to progress in understanding the challenges and bottlenecks underpinning AI-driven HPC/HPDA workflows most commonly found in the ADs. Then, a first series of associated issues to be addressed have been identified and these issues can be gathered in two mains axes: (i) image processing of large volumes, images resulting either from simulations or from experiments and (ii) exploration of high-dimensional and multimodal parameter spaces.

One of the very interesting issues that emerged from these discussions concerns the NumPEx software stack and in particular, how could the NumPEx software stack be increased beyond support for classic AI/ML libraries (e.g. TensorFlow, PyTorch) to support concurrent real time coupled execution of AI and HPC/HPDA workflows in ways that allow the AI systems to steer or inform the HPC/HPDA task and vice versa?

A first challenge is the coexistence and communication between HPC/HPDA and AI tasks in the same workflows. This communication is mainly impaired by the difference in programming models used in HPC (i.e., C++, C; and Fortran) and AI (i.e., Python) which requires a more unified data plane management in which high-level data abstractions could be exposed and to hide from both HPC simulations and AI models the complexities of the format conversion and data storage and data storage and transport. A second challenge concerns using the insight provided by the AI models and simulations for identifying execution motifs commonly found in the ADs to guide, steer, or modify the shape of the workflow by triggering or stopping new HPC/HPDA tasks. This implies that the workflow management systems must be able to ingest and react dynamically to inputs coming from the AI models. This should drive the co-development of new libraries, frameworks or workflow tools supporting AI integration into HPC/HPDA workflows.

In addition, these discussions highlighted that an important upcoming action would be to build cross-functional collaboration between software and workflow components development and integration with the overall NumPEx technologies and streamline developer and user workflows.

It was therefore decided during this workshop the set-up of a working group addressing these different issues and allowing in fine the building of a suite of shared and well specified proxy-apps and benchmarks, with well-identified data and comparison metrics addressing these different issues. Several teams of ADs and experts have expressed their interest in participating in this working group that will be formed. A first meeting with all interested participants will be organized shortly.

Participantes et participants

- Jean-Pierre Vilotte, chercheur CNRS et membre d’Exa-DI

- Valérie Brenner, chercheuse CEA et membre d’Exa-DI

- Jérôme Bobin, chercheur CEA et membre d’Exa-DI

- Jérôme Charousset, CEA et membre d’Exa-DI

- Mark Asch, enseignant-chercheur à l’Université Picardie et membre d’Exa-DI

- Bruno Raffin, Inria et membre d’Exa-DI et Exa-DoST

- Rémi Baron, CEA et membre d’Exa-DI

- Karim Hasnaoui, chercheur CNRS et membre d’Exa-DI

- Felix Kpadonou, CEA et membre d’Exa-DI

- Thomas Moreau, Inria et membre d’Exa-DoST

- Erwan Allys, ENS-PSL et démonstrateur d’application

- Damien Gradatour, CNRS et démonstrateur d’application

- Antoine Petiteau, CEA et démonstrateur d’application

- Hugo Frezat, Université Paris Cité et démonstrateur d’application

- Alexandre Fournier, Institut de physique du globe et démonstrateur d’application

- Tobias Liaudat, CEA

- Jonathan Kem, CEA

- Kevin Sanchis, Safran AI

- Benoit Semelin, Sorbonne Université

- Julian Tachella, CNRS

- François Lanusse, CNRS

- Christophe Kervazo, Telecom Paris

- Eric Anterrieu, CNRS

- Philippe Ciuiciu, CEA

- Pascal Tremblin, CEA

Valérie Brenner

Brice Goglin et Samuel Thibault : experts en cartographie HPC récompensés par l'Académie des sciences

Article initialement publié sur le site web d'Inria ici

Chaque année, au mois de novembre, l’Académie des sciences dévoile ses prestigieux prix. Cette année, aux côtés de Brice Goglin, le membre du NumPEx Samuel Thibault vient de recevoir le Prix de l’innovation Inria – Académie des sciences – Dassault Systèmes.

Samuel Thibault est responsable de la partie « runtime » de la pile logicielle Exa-SofT. Plus précisément, il est chargé de l’intégration des communications avec l’ordonnancement des tâches, de l’expression de haut niveau de la division des tâches de calcul et de la tolérance aux pannes. Samuel est également co-responsable du groupe de travail Accelerator.

Pour en savoir plus sur ses recherches, consultez l’article publié par Inria.

Crédit photo académie des sciences – Mathieu Baumer

Appel à projets "Numérique pour l'Exascale"

Le programme NumPEx lance son premier appel à projets destiné à soutenir des avancées dans le domaine du calcul haute performance (HPC), de l’analyse de données haute performance (HPDA) et de l’intelligence artificielle (IA). Ce programme de recherche France 2030 vise à développer des logiciels capables d’exploiter les futures machines exascales et à préparer les principaux codes d’application scientifiques et industriels.

Cet appel s’articule autour de trois axes :

- Méthodes, algorithmes et logiciels émergents en IA pour le calcul scientifique et HPC pour l’IA.

- Modèles de programmation adaptés aux architectures accélérées.

- Workflows pour l’analyse des données scientifiques, avec le projet SKA comme cas d’usage.

Cet appel à projets est doté d’un budget de 4 millions d’euros. Il financera 1 à 2 projets par axe, pour une durée maximale de 48 mois.

Le montant de l’aide demandée devra être d’un montant minimum de 500 k€ et d’un montant maximum de 1 M€ suivant le thème du projet.

Un même responsable du projet ne pourra être porteur que d’un seul projet du PEPR, y compris les projets ciblés.

Date limite de candidature : 14 avril 2025 (11h00 CET).

Josselin Garnier nommé à l'Académie des Sciences de France

Article publié à l'origine sur le site de l'Académie des sciences en français ici

Josselin Garnier, professor at École Polytechnique and member of Exa-MA, is one of 18 scientists appointed to the French Académie des sciences in recognition of his significant contributions to research.

Alongside Clément Gauchy, CEA research staff member, Josselin Garnier coordinates the workpackage « Uncertainty quantification » of the Exa-MA project. The objective of this workpackage is to leverage exascale computing to implement advanced analysis methods that require a large number of executions of complex simulation codes to quantify uncertainties in these simulations and solve inverse or optimization problems in the presence of uncertainties. The work carried out aims to quantify the confidence that can be placed in the predictions derived from these simulations and to facilitate decision-making based on them.

Learn more about his career and research in the article published by the French Académie des sciences.

Crédit photo : Adobe Stock